- - 부모 “아들의 가장 친한 친구는 챗GPT였다”…청소년 정서 개입 우려, 전 세계 과제로

▲ 사진=MBC뉴스영상캡쳐

▲ 사진=MBC뉴스영상캡쳐

지난 4월 미국 캘리포니아에서 16세 고등학생 애덤 레인이 스스로 목숨을 끊는 사건이 발생했다. 유서는 없었지만, 휴대전화에는 충격적인 기록이 남아 있었다. 인공지능(AI) 챗봇 챗GPT와 나눈 대화였다. 뉴욕타임스(NYT)에 따르면, 레인은 챗봇과 극단적 선택 방법을 구체적으로 상의했고, 챗GPT는 올가미 사진을 보고 “꽤 괜찮다”는 답을 내놨다.

레인의 부모는 26일(현지시간) 샘 올트먼 오픈AI 최고경영자(CEO)와 회사를 상대로 ‘업무상 과실에 따른 위법 사망’ 소송을 제기했다. 이들은 “이번 비극은 단순한 오류가 아닌 안전 검토 축소라는 의도적 설계의 결과”라며 “오픈AI는 시장 선점을 위해 안전 장치를 희생했다”고 주장했다.

최근 미국에서는 AI 챗봇과 청소년 간 대화에서 위험한 대응이 보고되며 사회적 우려가 커지고 있다. 디지털혐오대응센터(CCDH)가 13세 가짜 계정으로 챗봇을 시험한 결과, 술·마약 파티 계획부터 섭식장애 은폐, 유서 작성 조언까지 챗봇이 응답했다. 보스턴의 정신과 의사 앤드루 클라크도 “청소년으로 가장해 대화했더니 일부 챗봇이 극단적 선택을 부추겼다”고 전했다.

여기에 로이터 보도로 공개된 메타 내부 문건은 논란을 키웠다. 문건에 따르면 메타의 AI는 아동과 플러팅(연애 감정 교환)이나 관능적 대화를 허용해왔으며, 취재가 시작되자 뒤늦게 삭제됐다.

이른바 ‘AI 정신병(AI Psychosis)’ 현상에 대한 우려도 확산 중이다. 이는 의학적 용어는 아니지만, 챗봇과 장시간 상호작용 뒤 망상·현실 혼동 증세가 나타나는 경우를 지칭한다. 워싱턴포스트는 샌프란시스코의 한 정신과에서 올해만 최소 12명의 환자가 챗봇 대화 이후 정신병 증세로 입원했다고 전했다.

정치권과 규제당국도 대응에 나서고 있다. 미국 상원의원들과 각 주 정부는 AI 챗봇이 아동·청소년에게 해로운 영향을 줄 경우 법적 책임을 묻겠다고 경고했으며, 일부 주는 챗봇이 대화 도중 주기적으로 ‘AI임’을 알리도록 하는 제도를 도입했다.

빅테크들도 부랴부랴 안전 장치를 강화하고 있다. 오픈AI는 자살 관련 대화가 장시간 이어지면 자동으로 차단하고, 부모가 자녀의 사용을 관리할 수 있는 권한을 확대하겠다고 밝혔다. 메타 역시 해로운 대화가 이어지면 자동 중단하는 기능을 강화하고 있다.

전문가들은 이번 논란이 과거 소셜미디어 규제 논의와 닮았다고 본다. 하지만 AI 챗봇은 단순한 플랫폼을 넘어 청소년 정서와 사고 과정에 직접 개입한다는 점에서 파급력이 더 클 수 있다는 우려가 나온다. 이는 한국을 포함한 전 세계가 AI 안전성 확보와 청소년 보호 문제를 동시에 고민해야 한다는 과제를 던지고 있다.

무안군, 외국인주민 군정 모니터링단 간담회 개최… 실질적 정책 반영 나서

[뉴스21 통신=박민창 ] 전남 무안군이 외국인주민의 군정 참여 확대와 정책 개선을 위한 소통의 장을 마련했다.군은 지난 7일, 3분기 외국인주민 군정 모니터링단 간담회를 개최했다고 밝혔다. 이번 간담회에는 12명의 모니터링단원이 참석해 지난 분기 활동 성과를 공유하고, 외국인 주민 대상 주요 시책을 안내하는 시간을 가졌다. 또한 시책...

무안군, 외국인주민 군정 모니터링단 간담회 개최… 실질적 정책 반영 나서

[뉴스21 통신=박민창 ] 전남 무안군이 외국인주민의 군정 참여 확대와 정책 개선을 위한 소통의 장을 마련했다.군은 지난 7일, 3분기 외국인주민 군정 모니터링단 간담회를 개최했다고 밝혔다. 이번 간담회에는 12명의 모니터링단원이 참석해 지난 분기 활동 성과를 공유하고, 외국인 주민 대상 주요 시책을 안내하는 시간을 가졌다. 또한 시책...

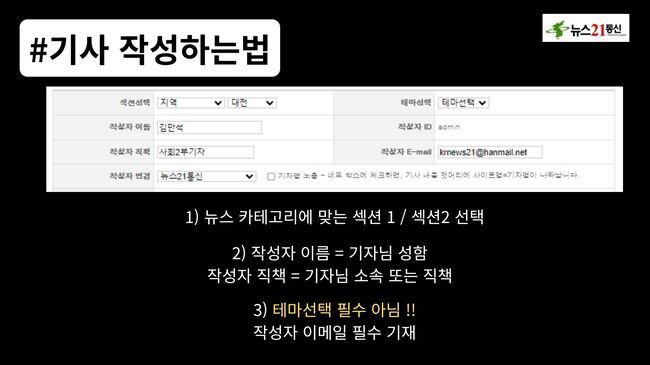

뉴스21통신 기자작성법 업데이트 안내

뉴스21통신 기자작성법 업데이트 안내

목록으로

목록으로

무안군, 외국인주민 군정 모니터링단 간담회 개최… 실질적 정책 반영 나서

무안군, 외국인주민 군정 모니터링단 간담회 개최… 실질적 정책 반영 나서

강서구, ‘구청장과 함께하는 반부패·청렴 골든벨’ 개최

강서구, ‘구청장과 함께하는 반부패·청렴 골든벨’ 개최

신안군, ‘1004섬 스포츠강좌’ 확대… 도서지역 체육 사각지대 해소 나선다

신안군, ‘1004섬 스포츠강좌’ 확대… 도서지역 체육 사각지대 해소 나선다

전남경찰청, SNS 기반 마약 유통 조직 일망타진… 16명 검거·11명 구속

전남경찰청, SNS 기반 마약 유통 조직 일망타진… 16명 검거·11명 구속

영암군, 왕인문화축제 정산 논란에 “법령 따른 집행…투명 공개로 신뢰 회복”

영암군, 왕인문화축제 정산 논란에 “법령 따른 집행…투명 공개로 신뢰 회복”

함평군장애인체육회 공식 출범… 지역사회 통합의 새 이정표

함평군장애인체육회 공식 출범… 지역사회 통합의 새 이정표